introducción al movimiento aleatorio: distribuciones.

Anuncio

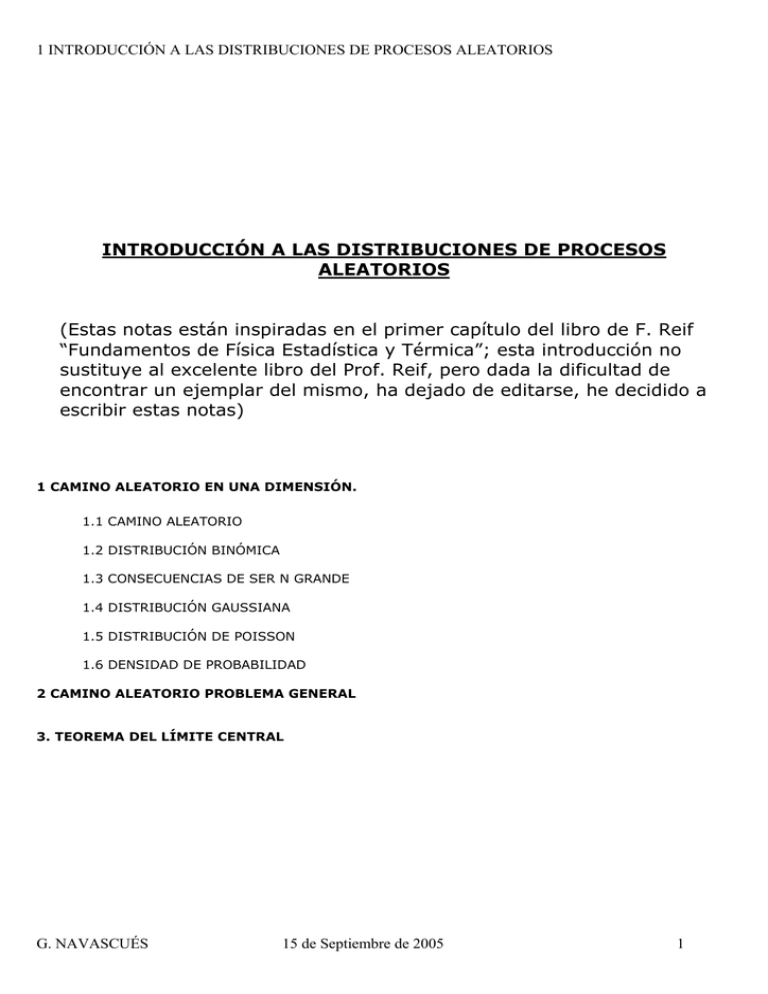

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS

ALEATORIOS

(Estas notas están inspiradas en el primer capítulo del libro de F. Reif

“Fundamentos de Física Estadística y Térmica”; esta introducción no

sustituye al excelente libro del Prof. Reif, pero dada la dificultad de

encontrar un ejemplar del mismo, ha dejado de editarse, he decidido a

escribir estas notas)

1 CAMINO ALEATORIO EN UNA DIMENSIÓN.

1.1 CAMINO ALEATORIO

1.2 DISTRIBUCIÓN BINÓMICA

1.3 CONSECUENCIAS DE SER N GRANDE

1.4 DISTRIBUCIÓN GAUSSIANA

1.5 DISTRIBUCIÓN DE POISSON

1.6 DENSIDAD DE PROBABILIDAD

2 CAMINO ALEATORIO PROBLEMA GENERAL

3. TEOREMA DEL LÍMITE CENTRAL

G. NAVASCUÉS

15 de Septiembre de 2005

1

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

1 CAMINO ALEATORIO EN UNA DIMENSIÓN

1.1 CAMINO ALEATORIO

Considere un suceso cuyo resultado sólo puede ser uno de dos posibles. Ejemplo: al dejar caer una

moneda sólo es posible que al llagar al suelo muestre una de las dos caras. Otro posible ejemplo podría

ser el movimiento idealizado de un borracho: el suceso consistiría en dar un paso y que este sólo lo

pudiera ser dado a la derecha o a la izquierda y con un alcance fijo. Otro ejemplo: al introducir una

molécula en una caja sólo es posible colocarla en una parte de la caja o en el resto. Otro: al observar en

un cierto instante el átomo de nitrógeno en una molécula de amoniaco podremos ver el átomo en una de

las dos posibles posiciones de equilibrio, a uno u otro lado de la triada de átomos de hidrógeno. Otro

ejemplo más: cuando se observa el momento magnético (espín) de un electrón sólo puede estar en

cualquiera de los dos sentidos, con igualdad de probabilidad si no hay presencia de un campo magnético.

Llamo p a la probabilidad de que el suceso acabe en uno de sus dos posibles resultados y q=1p a la probabilidad de que acabe en el otro. Tal como las defino estas probabilidades están

normalizadas a la unidad, es decir la suma de probabilidades es uno. En el caso de la posición del átomo

de nitrógeno en la molécula del amoniaco las probabilidades p y q son iguales por simetría, por tanto

p=q=1/2. Lo mismo pasaría básicamente con la moneda salvo que estuviese trucada. En el caso del

borracho las probabilidades dependen de las circunstancias: si hay un bar a la derecha o a la izquierda, si

la calle está en cuesta, ... En ejemplo de la molécula y la caja las probabilidades dependerán del volumen

de cada una de las partes de la caja. Si el espín del electrón está en un campo magnético su orientación

en el sentido del campo estará primada y por tanto p será mayor que q (o viceversa).

Vamos a continuación a estudiar los resultados de una sucesión de sucesos de este tipo. La condición

fundamental en esta cadena de sucesos es que son estadísticamente independientes, con esto se

quiere decir que cada suceso ocurre independientemente de los demás. Es decir p y q tendrán el mismo

valor en cada suceso; por ejemplo en el caso del amoniaco siempre que observemos al átomo de

nitrógeno tendremos la misma probabilidad de encontrarlo a uno u otro lado de la triada de hidrógenos:

q=p=1/2; el borracho tendrá siempre la misma probabilidad de dar el paso a la derecha, etc. La sucesión

de sucesos estadísticamente independientes se conocen como caminos aleatorios y si, como en los

ejemplos dados, sólo hay dos resultados posibles en cada suceso el problema se llama camino aleatorio

en una dimensión (este nombre proviene de casos como el del borracho o el del espín en donde sólo es

importante una dirección). El problema general puede ser mucho más complicado pero las ideas son las

mismas, por ejemplo el borracho podría dar pasos en varias direcciones e incluso dar pasos de distinta

longitud, su movimiento podría ser similar al de una partícula en un fluido en el que asimilamos los

posibles pasos del borracho a las distancias recorridas por la partícula entre choques con las restantes

partículas del fluido. El caso de la moneda se puede complicar un poco si tiramos un dado en vez, en el

que el resultado es uno de seis posibles en vez de los dos posibles de la moneda, si se usa alguno de los

dados del juego de rol el problema se complica aún más. El conjunto de resultados podría ser un continuo

en vez de un número finito. Volveré al caso general más adelante.

1.2 DISTRIBUCIÓN BINÓMICA

La notación que seguiré de momento es utilizar p y q para las probabilidades de los dos posibles

resultados de un suceso que es la más cómoda, sin embargo más adelante generalizaré los resultados al

camino aleatorio general donde es más apropiada otra notación: p1 que hace el papel de p y p2=1-p1 que

hace el papel de q. La normalización exige entonces que:

p + q =1 o

i=M

∑p

i =1

i

=1

donde M=2. Observe que la segunda expresión, excesivamente alambicada para el presente caso, es sin

embargo más apropiada para el caso más general donde M>2, como por ejemplo tirar un dado en cuyo

suceso M=6, hay 6 resultados posibles.

G. NAVASCUÉS

15 de Septiembre de 2005

2

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

Considere ahora la repetición del mismo suceso hasta N veces, por ejemplo nuestro borracho da N pasos

(o se observa el espín del electrón N veces consecutivas o se ven N electrones en las mismas

condiciones). Si p es la probabilidad de que al dar un paso este sea dirigido a la derecha, que tomo como

sentido positivo del eje X y q a la izquierda (o p es la probabilidad de ver al espín en sentido del campo y

q en sentido opuesto al campo), la probabilidad total de que los n primeros pasos sean todos hacia la

derecha y los restantes, N-n, a la izquierda debe ser:

prob. de dar n pasos seguidos a la derecha y luego dar N-n a la izquierda =

(=prob. de ver n espines paralelos al campo y el resto antiparalelos) =

= p p p . . . p q q q . . . . q = pnqN-n

n

N-n

La probabilidad total, debido a la independencia estadística, es producto de probabilidades. En cada caso

se pueden responder a cuestiones diferentes, por ejemplo si la longitud del paso es L, después de estos N

pasos (sucesos) el borracho se ha alejado una distancia:

x = nL − ( N − n) L = ( 2n − N ) L

o la magnetización total de N espines en donde los N primeros están en la dirección positiva y el resto e la

negativa es (observe que ordeno los electrones por estar en cajas diferentes, lo que les hace

distinguibles):

M = nµ − ( N − n ) µ = ( 2 n − N ) µ

µ es el momento magnético del espín electrónico. Para llegar a la misma posición nuestro borracho podría

haber dado el mismo número de pasos a la derecha y a la izquierda pero en cualquier otro orden (o

equivalentemente: para tener el mismo momento total de los espines da lo mismo cuales son los n

electrones que están en una dirección, hacia arriba, y cuales los que están en la otra, hacia abajo). ¿De

cuantas formas distintas se pueden dar n pasos a la derecha y N-n pasos a la izquierda? (¿o de cuantas

maneras puedo poner n espines hacia arriba y el resto hacia abajo?). La respuesta es equivalente a

buscar todas las posibles ordenaciones de la n “pes” y las N-n “cues” de la expresión de más arriba, es

decir todas las permutaciones entre “pes” y “cues”, N!, eliminando las permutaciones entre sólo “pes” y

las permutaciones entre sólo “cues” es decir: N!/[n!(N-n)!]. Así que finalmente el número de posibilidades

distintas para que el borracho llegue a la posición x (o el momento magnético total sea M), o lo que lo

mismo que de n pasos a la derecha y N-n pasos a la izquierda (n espines hacia arriba y N-n hacia abajo),

no importando el orden, es el número combinatorio:

⎛N⎞

N!

≡ ⎜⎜ ⎟⎟ .

n!( N − n )! ⎝ n ⎠

Como cualquiera de estas posibilidades tiene el mismo número de pasos a la derecha (n) y a la izquierda

n

N −n

, entonces la probabilidad total de que

(N-n), cualquiera de ellas tiene la misma probabilidad total: p q

nuestro borracho llegue a x, o lo que es lo mismo de que dé n pasos a la derecha (o que los espines

tengan momento magnético total M o que es lo mismo haya n espines orientados hacia arriba) es1:

Prob[x]=Prob[(2n-N)L]=Prob’[n]=Probabilidad de una de las posibilidades x Número posibilidades=

= pnq N −n

1

⎛N⎞

N!

= p n q N − n ⎜⎜ ⎟⎟ ≡ PN (n)

n! ( N − n)!

⎝n⎠

Observe que en la notación que usaremos luego esta expresión, se rescribe como: PN ( n1 , n 2 )

= p1 1 p 2

n

n2

N!

; aparentemente

n1!n2 !

la las variables pes y enes parecen independientes pero no: p1+p2 =1 y n1+n2 =N.

G. NAVASCUÉS

15 de Septiembre de 2005

3

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

De los N pasos (sucesos) puede ser que ninguno fuera a la derecha (n=0) o por el contrario, en el otro

extremo de posibilidades, todos fueran a la derecha (n=N) (o, de forma similar, la orientación de los

espines puede ir desde estar todos hacia abajo (n=0) a estar todos hacia arriba (n=N)). Así la expresión

anterior es válida para n=0,1,2,3,...,N. La PN está normalizada ya que:

n= N

∑ PN (n) =

n =0

n= N

∑p

n

q N −n

n =0

N!

= (q + p) N = 1N = 1.

n!( N − n)!

Observe que PN(n) son los distintos términos del binomio de Newton, por eso a esta distribución de

probabilidades PN se le llama distribución binómica, también es conocida como distribución normal.

A continuación presento un ejemplo numérico en donde N=20 y la probabilidad de cada uno de los dos

resultados del suceso es la misma, es decir p=q=1/2. Este ejemplo corresponde al caso de la molécula de

amoniaco mencionada, o al de la moneda perfecta, o al de la molécula introducida en una caja con dos

partes iguales. También al caso del borracho suponiendo que la probabilidad de dar el paso a la derecha

es la misma que la probabilidad de que lo dé a la izquierda o al de los espines sin campo magnético donde

es igual de probable ver a cada espín en cada uno de los dos sentidos. Supongo que estoy en este último

caso y analizaré los resultados que presento en el diagrama siguiente:

PN = 20 (n); PN' = 20 ( x)

0.18

0.16

0.14

0.12

0.10

0.08

0.06

0.04

0.02

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

(n)

-20

-18

-16

-14

-12

-10

-8

-6

-4

-2

0

2

4

6

8

10

12

14

16

18

20

(x/L)

Se observa los siguientes comportamientos de la probabilidad P como función de n. Primero crece para

luego decrecer con n. En otras palabras la probabilidad de que de los 20 pasos todos en un mismo sentido

tiene que ser muy pequeña: P20(0)=P20(20)=(1/2)20 que es despreciable frente a otras posibilidades por lo

que debe haber un máximo (no siempre esto es así pero es el caso usual). La distribución de

probabilidades es simétrica como corresponde al hecho de que por simetría (la simetría la impone el que p

sea igual a q) la probabilidad de dar n pasos a la derecha y el resto a la izquierda es la misma que dar los

n pasos a la izquierda y el resto a la derecha: P20(n)=P20(20-n). El máximo ocurre para n=10, es decir la

mitad de pasos en cada sentido, en este caso hay más combinaciones para dar los 20 pasos totales y por

lo tanto la probabilidad total es máxima. ¡Cuidado! si N fuese impar el máximo correspondería a dos

valores de n, por ejemplo en el caso N=21 las mayores posibilidades corresponden a 10 pasos a la

derecha y 11 a la izquierda o viceversa 10 pasos a la derecha y 11 a la izquierda.

El caso del borracho nos permite estudiar el problema con otra variable y como con todo cambio de

variable podemos volver a describir la misma situación con otras palabras que pueden ser más

convenientes por cualquier razón. En vez de hablar de pasos a la derecha podemos hablar de distancia

alcanzada al final de los 20 pasos: dar todos los pasos en uno u otro sentido es equivalente a decir que el

G. NAVASCUÉS

15 de Septiembre de 2005

4

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

borracho a llegado a x=20L o x=-20L. El máximo de probabilidad corresponde a haber dado los mismos

pasos en cada sentido y por lo tanto acaba en el mismo sitio x=0, etc. En el diagrama anterior presento

las probabilidades en función de las variables. Observe que dada la naturaleza del problema la variable x

toma valores discontinuos: -20L, -18L, .... y que los saltos de x van de 2L en 2L.

Es útil expresar la probabilidad en una y otra variable. De las relaciones elementales

x = nL − ( N − n) L, N = n + ( N − n), n =

se llega inmediatamente a

PN (n) = p n q N − n

1

1

( N + x / L), N − n = ( N − x / L) ,

2

2

N!

N!

= p ( N + x / L) / 2 q ( N − x / L) / 2

= P ' ( x)

[( N + x / L) / 2]![( N − x / L) / 2]! N

n!( N − n)!

En el caso de que las probabilidades de los dos

resultados posibles de suceso no sean iguales la

distribución binómica deja de ser simétrica. En la

figura de la derecha se muestran esquemáticamente

cómo se desvía la distribución de la simétrica cuando

p y q son diferentes.

Ahora supongo que el proceso de los N pasos del

borracho se repite N veces (con el mismo borracho

si es capaz o con N borrachos idénticos), o en el caso

de los espines observamos N veces a los N

electrones. Cada una de estas veces constituirá un

experimento. En cada uno de los N experimentos

tendremos un posible resultado final como

consecuencia de los resultados de los N sucesos del

experimento: la distancia recorrida final x en el caso

del borracho es la suma de capa paso o la

magnetización total de los espines es la suma de la

de cada espín. Si N es suficientemente grande el

valor medio de los resultados es el valor medio

esperado de cada experimento, es decir de la

distribución PN se obtiene el número medio de n

< n >=

p<q

p>q

n= N

∑ nP

n =0

N

(n).

y de este, según sea el problema, la distancia media recorrida por el borracho:

< x >=< n > L − ( N − < n >) L = (2 < n > − N ) L = ( 2 pN − N ) L = ( p − q ) NL

o el momento magnético medio de los espines:

< M >=< n > µ − ( N − < n >) µ = ( 2 < n > − N ) µ = ( 2 pN − N ) µ = ( p − q ) Nµ

Estrictamente N debería ser infinito. Observe que el <n> debe coincidir con el máximo si la distribución es

simétrica. Una información importante de las distribuciones es la desviación media ∆n del valor medio.

Este dato es muy importante ya que nos da idea de lo que podemos esperar de un experimento. Lo más

probable es que el resultado este comprendido en el intervalo definido por <n>±∆n. Si la desviación media

es muy pequeña tenemos una posibilidad muy grande de que el resultado del experimento sea el valor

medio o próximo a él, en caso contrario el resultado de un experimento probablemente sea cualquiera de

los posibles. La desviación media da también idea de la anchura de la distribución, o lo que es lo mismo

del rango de valores de n donde la probabilidad es suficientemente grande.

G. NAVASCUÉS

15 de Septiembre de 2005

5

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

No hay una manera objetiva de determinar ∆n pero hay muchas razonables. En el curso usaremos la más

empleada en todos los ámbitos donde se utiliza la estadística matemática, es la llamada desviación

estándar definida como la raíz cuadrada del valor medio de la desviación cuadrática:

(∆n) 2 ≡< (n − < n >) 2 >=< n 2 > − < n > 2

Observe que ingenuamente se podría definir la desviación como <(n-<n>)>, es decir sin el cuadrado pero

desviaciones positiva y negativas se anularían entre sí dando engañosamente una desviación nula. El

cuadrado se podría evitar utilizando el valor absoluto, <|n-<n>|>, pero es más incómodo de manejar.

Por todo eso se utiliza usualmente la desviación cuadrática media y luego se extrae la raíz. La mayoría de

las veces la distribuciones no son simétricas (ver figura más arriba) y por tanto, por definición, la

desviación cuadrática media da una idea de como se desvía la distribución a un lado y otro del valor

medio, aunque en un lado se desvíe un poco más y otro un poco menos de lo indicado por la desviación

estándar. Si se está interesado en distinguir la desviación a cada lado del valor medio no hay más que

aplicar la definición independientemente a cada lado. Todas estas consideraciones sobre la desviación son

generales, ahora las aplicaré a la distribución binómica. Primero evalúo los valores medios de n y n2:

N

N

⎛N⎞ N

⎛N⎞

∂ n N −n ⎛ N ⎞

∂ N

< n >= ∑ nPN (n) = ∑ np n q N − n ⎜⎜ ⎟⎟ = ∑ p

p q ⎜⎜ ⎟⎟ = p ∑ p n q N − n ⎜⎜ ⎟⎟ =

∂p

∂p 0

0

0

0

⎝n⎠

⎝n⎠

⎝n⎠

=p

∂

( p + q) N = pN ( p + q) N −1 = pN ,

∂p

Este resultado era previsible. Si la probabilidad de que el borracho de un paso a la derecha es p, el

número de pasos medio a la derecha será pN. Observe lo útil que es el truco de considerar p

p

n

como

∂ n

p . Ahora calculo el valor medio de n2 utilizando el truco dos veces:

∂p

N

N

⎛ N ⎞ N ⎡ ∂ ⎤⎡ ∂ ⎤

⎛ N ⎞ ⎡ ∂ ⎤⎡ ∂ ⎤ N

⎛N⎞

< n 2 >= ∑ n 2 PN (n) = ∑ n 2 p n q N − n ⎜⎜ ⎟⎟ = ∑ ⎢ p ⎥ ⎢ p ⎥ p n q N − n ⎜⎜ ⎟⎟ = ⎢ p ⎥ ⎢ p ⎥ ∑ p n q N − n ⎜⎜ ⎟⎟ =

0

0

0 ⎣ ∂p ⎦ ⎣ ∂p ⎦

⎝n⎠

⎝ n ⎠ ⎣ ∂p ⎦ ⎣ ∂p ⎦ 0

⎝n⎠

⎡ ∂⎤

⎡ ∂ ⎤⎡ ∂ ⎤

= ⎢ p ⎥ ⎢ p ⎥ ( p + q ) N = ⎢ p ⎥ pN ( p + q) N −1 = pN ( p + q) N −1 + p 2 N ( N − 1)( p + q) N − 2 =

⎣ ∂p ⎦

⎣ ∂p ⎦ ⎣ ∂p ⎦

= pN + p 2 N ( N − 1) = pN (1 + pN − p) = ( pN ) 2 + pqN =< n > 2 + pqN

de donde se llega a

(∆n) 2 ≡ pqN (∆n) 2 ≡ pqN

que en el caso del borracho se transforma en:

(∆x) 2 ≡ 4 L2 (∆n) 2 ≡ 4 L2 pqN

y en el de los espines en:

G. NAVASCUÉS

15 de Septiembre de 2005

6

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

(∆M ) 2 ≡ 4µ 2 (∆n) 2 ≡ 4µ 2 pqN

que se obtienen inmediatamente debido a la linearidad de n con x (o µ) (¡compruébelo!). Que la

desviación media sea pequeña, algo que usualmente se desea, no es útil si el valor medio no es mucho

más pequeño aún, por tanto más importante que la propia desviación es la relación ∆n / < n > que para la

distribución binómica resulta ser:

∆n

=

<n>

p 1

→0

q N

N →∞

y por tanto para los dos ejemplos que estoy discutiendo:

∆x

<x>

o

2 pq 1

∆µ

=

→0

< µ > ( p − q) N

N →∞

La linealidad entre n y x (o µ) vuelve a dar esencialmente el mismo resultado.

1.3 CONSECUENCIAS DE SER N GRANDE

Este resultado es muy importante y tiene consecuencias cruciales en física como veremos durante el

curso. ¿Qué significa este resultado? Consideremos el caso del borracho con p=q=1/2 hay la misma

probabilidad de que de el paso a la derecha como lo de a la izquierda o en el caso de los espines cada

espín puede estar dirigido en los dos sentidos con igual probabilidad. Hagamos N (N muy grande)

experimentos en el que en cada uno de ellos el borracho da 2 pasos (N=2) o en el que cada uno de ellos

observamos a dos espines. En cada experimento puede ser que le borracho de 2 pasos a la derecha (haya

dos espines hacia arriba), un paso a la derecha con dos posibilidades: que el paso a la derecha sea el

primero o el segundo (un espín hacia arriba y otro hacia abajo, lógicamente son dos posibilidades) o cero

pasos a la derecha (los dos espines hacia abajo). El valor medio de pasos a la derecha (de espines hacia

arriba) es lógicamente 1, tal como predice la expresión <n>=pN=1/2x2=1. La desviación estándar da

∆n=√(pqN)=1/√2 que es un valor del mismo orden del valor medio, en otras palabras los resultados más

lejanos al valor medio 1 (en este caso los únicos: 2 y 0) pueden ser tan casi tan probables como el propio

valor medio, la capacidad de predicción se pierde. La relación entre la desviación estándar y el valor

medio es ∆n/<n>=1/√2≈0.707 que evidentemente no es muy pequeña indicando lo que acabo de discutir.

Volvamos a realizar N experimentos pero ahora en cada uno de ellos el número de pasos N que tiene que

dar el borracho es muy grande (o el número de espines), por ejemplo 1024 (del orden del número de

Avogadro de cualquier sistema macroscópico que se precie, así serán los sistemas de espines que

estudiemos más adelante). Formalmente todo es igual pero numéricamente la situación cambia

drásticamente con consecuencias enormemente prácticas: ahora el valor medio de n es N/2=.5x1024

(como es lógico si se dan N pasos y tiene la misma probabilidad de darlos en un sentido u otro el valor

medio es N/2, como antes salvo que ahora N es muy grande), la desviación estándar es

∆n=√(N/4)=.5x1012. Ambos valores son grandes por serlo N pero siendo el valor medio proporcional a N y

la desviación a √N, si N es grande, la desviación es despreciable frente al valor medio. Esto es lo que

describe el cociente ∆n/<n> que en este caso sería 10-12<<<1 Las consecuencia es que si hacemos un

sólo experimento podemos predecir el resultado: el número de pasos a la derecha serán del orden de

N/2: N/2± ∆n =.5x1024 ± .5x1012 ≈.5x1024. No es imposible que sean en un número diferente pero

extremadamente improbable. Tan improbable como tan seguros estamos de ir al aula sin pensar por un

momento que existe la posibilidad no nula de que las moléculas del aire se agrupen en una esquina de sus

esquinas impidiéndonos respirar por algunos momentos. Observe que variaciones del orden de la unidad

(e incluso mucho más grandes) no juegan ningún papel sobre valores del orden de N.

G. NAVASCUÉS

15 de Septiembre de 2005

7

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

En las siguientes figuras se muestra la desviación estándar en una posible distribución donde esta es del

orden del valor medio y otra en la que es mucho más pequeña (en este caso los valores de PN para

valores distintos del valor medio son tan pequeños que no se aprecian en la figura):

aunque en esta

escala

PN (n )

2∆n → ∞

2∆n

<n>

<n>

1.4 DISTRIBUCIÓN GAUSSIANA

En todo este estudio hay un problema práctico. Para que sea útil N debe ser grande y si lo es nos

encontramos con la necesidad de evaluar factoriales de números gigantescos. En la práctica es imposible

incluso con los ordenadores más potentes que pudiéramos imaginar. Sin embargo, como veremos con

frecuencia, el origen de la dificultad es también la clave de la solución: si n es grande, del orden del

número de Avogadro en nuestros problemas, los saltos de una unidad en la variable entera n son

insignificantes, imposibles de discernir tampoco ni con el más potente de los ordenadores, por lo que

podemos considerar esta variable como continua, aunque sólo los valores de n entero tienen sentido en el

problema que se estudia. Al ser N grande la distribución es muy picuda (ver figura anterior) y por tanto el

máximo y el valor medio son prácticamente los mismos. Como función continua de n podemos desarrollar

PN(n) en serie de Taylor alrededor del máximo, pero en vez de hacerlo con PN lo hacemos con su

logaritmo que es una función muchísimo más suave en sus variaciones (recuerde que la función que más

varía es la potencial y sin embargo su logaritmo es una constante) y podremos truncar el desarrollo con

menos términos. Así tendremos:

⎞

⎛ d2

( n − < n >) 2

⎛ d

⎞

Ln[PN (n)] = Ln[PN (< n >)] + ⎜ Ln[PN (n)]⎟

(n − < n >) + ⎜⎜ 2 Ln[PN (n)]⎟⎟

+ ....

2!

⎝ dn

⎠ n =< n >

⎠ n =< n >

⎝d n

El término lineal desaparece al ser PN (y LnPN) máximo en n=<n>. Suprimiendo el logaritmo se llega a:

⎫⎪

⎧⎪⎛ d 2

⎞

( n − < n >) 2

⎟

⎜

PN (n) = PN (< n >) exp⎨⎜ 2 Ln[PN (n)]⎟

+ ....⎬

2!

⎪⎭

⎪⎩⎝ d n

⎠ n =< n >

si n-<n> es suficientemente pequeño podemos suprimir los términos no escritos que son al menos del

orden de (n-<n>)3 y por tanto despreciables frente al primer término que es cuadrático y quedando:

⎧⎪⎛ d 2

⎞

(n− < n >) 2 ⎫⎪

⎟

⎜

PN (n) = PN (< n >) exp⎨⎜ 2 Ln[PN (n)]⎟

⎬

2!

⎪⎭

⎪⎩⎝ d n

⎠ n =< n >

Para hacer más clara la simplificación a la que hemos llegado observe que la distribución depende de tres

constantes A, B y <n>:

G. NAVASCUÉS

15 de Septiembre de 2005

8

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

⎧ ( n − < n >) 2 ⎫

PN (n) = A exp⎨ B

⎬

2

⎭

⎩

A es un factor que se puede fijar fácilmente exigiendo la normalización de la distribución, <n> es otra

constante que sabemos lo que representa y finalmente B que se determina con poco de álgebra de su

propia definición, usando la distribución binómica para PN y teniendo en cuenta que n es grande. Con todo

esto se llega a cualquiera de estas dos expresiones (ver libro de Rief para los detalles algebraicos):

PN (n) =

⎧ (n − pN ) 2 ⎫

exp⎨−

⎬=

2 Npq ⎭

2πNpq

⎩

1

⎧ ( n − < n >) 2 ⎫

1

exp⎨−

⎬

2(∆n) 2 ⎭

2π ∆n

⎩

1

Lo importante del resultado es que para conocer la probabilidad para un valor de n basta evaluar una

simple exponencial ¡¡¡ compare esta evaluación con el cálculo de un número combinatorio !!!

Naturalmente es una aproximación que está basada en que n-<n> es pequeño pero se puede demostrar

(ver libro de Reif) que para los valores en que la aproximación no es buena el valor de PN es tan

insignificante que ya da igual que la aproximación sea incluso muy mala. Una exposición más rigurosa

(ver Reif) exige que Npq sea >>1, es decir no hay ningún problema si N es grande salvo que p o q sean

demasiado pequeños. En este caso veremos que hay otra aproximación que vuelve a evitar calcular

factoriales de números grandes.

Esta distribución exponencial se llama distribución gaussiana y usualmente se utilizan las letras griegas

µ (¡no confundir con el momento magnético) y σ para representar el valor medio y la desviación estándar:

PN (n) =

con

µ ≡< n >= pN y σ ≡ ∆n =

⎧ (n − µ ) 2 ⎫

exp⎨−

⎬

2σ 2 ⎭

2π σ

⎩

1

1

pqN .

1.5 DISTRIBUCIÓN DE POISSON

Hemos visto que la distribución gaussiana es una buena aproximación cuando qpN>>1. Siendo los casos

interesantes los que tienen N grande la distribución de gauss será muy útil la mayoría de las veces. Pero

puede ocurrir que p (o q) fuera tan pequeño que frustrase la condición anterior. En este caso vamos a ver

que existe otra aproximación que evita otra vez tener que usar la distribución exacta y por tanto evita la

evaluación de factoriales de grandes números.

Observe que si p<<<1 y q=1-p≈1 la distribución es

extremadamente asimétrica, tanto que el máximo está

cerca o en el valor n=0 (ver figura) de tal modo que sólo

las probabilidades de n pequeño tienen un valor

significativo: tan pequeño es p que es altamente

improbable que salga el resultado desfavorable más de

unas pocas veces. Así que lo importante es tener una

buena aproximación de PN(n) para valores pequeños de n.

Primero voy a obtener dos resultados basados en que

p<<<1 y n<<N (problema 1.9 del libro de Reif):

[

a) Ln (1 − p )

b)

N −n

] = ( N − n) Ln(1 − p) ≈ ( N − n)(− p)

N!

= N ( N − 1)( N − 2)...( N − n + 1) ≈ N n

( N − n)!

G. NAVASCUÉS

y para n << N

[

]

Ln (1 − p) N − n ≈ − pN = − < n >)

para n << N

15 de Septiembre de 2005

9

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

Entonces:

PN (n) = p q

n

N −n

n

( pN ) n

N!

N!

n

N −n

n N

= p (1 − p )

≈p

exp{− pN }

exp{− pN } =

n!

n!

n!( N − n)!

n!( N − n)!

al producto pN, que es el valor medio <n>, se suele rescribirlo en este límite con la letra griega λ:

PN (n) =

λn

n!

exp{− λ }

que es conocida como distribución de Poisson. Observe que la expresión vuelve a ser muy fácil de

evaluar ya que el factorial que aparece es el de n y n debe ser pequeño; para valores grandes de n la

distribución no es una buena aproximación pero para esos valores la probabilidades ya son prácticamente

nulas. A partir de la distribución de Poisson se puede evaluar el promedio de cualquier variable de interés

en cualquier sistema.

1.6 DENSIDAD DE PROBABILIDAD

Aprovechando el ejemplo del borracho (o el de los espines) podemos introducir el concepto de densidad

de probabilidad, mucho más práctico que el de la probabilidad en la mayoría de los problemas físicos

que estudiaremos. Si n la hemos considerado continua para manejarla con más facilidad y poder obtener

aproximaciones prácticas lo mismo podemos hacer con la variable x que es la distancia a la que llega el

borracho. Aunque la consideremos continua está claro que, como la variable n, sólo tiene sentido como

múltiplos del L (recuerde que L es el alcance de cada paso). Con el cambio de variables x=nL-(N-n)L

podemos obtener la aproximación gaussiana para PN(x):

⎧ ( x − < x >) 2 ⎫

2L

exp⎨−

⎬

2(∆x) 2 ⎭

2π ∆x

⎩

1

PN ( x) =

para los espines tendríamos:

PN ( M ) =

⎧ ( µ − < µ >) 2 ⎫

2µ

exp⎨−

⎬

2(∆µ ) 2 ⎭

2π ∆µ

⎩

1

Pero lo que busco es otra cosa ligeramente diferente: la probabilidad P(x,x+dx) de que el borracho en el

experimento (es decir después de dar N pasos) se encuentre en un intervalo (x,x+dx) de distancias en

vez de a una determinada distancia x (o la probabilidad P(M,M+dM) de que el sistema de espines en el

experimento (es decir en una observación de los N espines) se tenga una magnetización cuyo valor se

encuentre en el intervalo M,M+dM. Ese intervalo es infinitesimal pero en el que caben varias posibles

posiciones finales del borracho o posibles valores de M (ver figura) . Esto tiene sentido ya que N es

enorme y los valores de interés de x (M), los cercanos al valor medio que son los que tienen una

probabilidad significativa de que ocurran, son gigantescos en

comparación con 2L (2µ) y desde este punto de vista en un

intervalo dx (dM) puede haber varios saltos de 2L (2µ). Entonces

es evidente que

ΡN ( x, x + dx) = PN ( x) + PN ( x + 2 L) + ... + PN ( x + dx) = PN ( x)

x

x+dx

2L

dx

= p N ( x)dx

2L

Donde la última igualdad se obtiene teniendo en cuenta que como

el intervalo es pequeño las probabilidades en el intervalo (x, x+dx)

difieren poco entre si: PN ( x) ≈ PN ( x + 2 L) ≈ ... ≈ PN ( x + dx ) , de

manera que se toma una de ellas y se multiplica por su número.

En el resultado al factor, PN ( x )

1

= p N ( x) , que multiplica a dx se le llama densidad de probabilidad

2L

(¡¡¡no es una probabilidad!!!) es una función de la variable x que multiplicada por el diferencial

G. NAVASCUÉS

15 de Septiembre de 2005

10

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

de x da, ahora si, la probabilidad de encontrar el sistema (el borracho) en el intervalo (x,x+dx)

después del experimento. Observe que necesariamente la densidad de probabilidad pN tiene

dimensiones de inversa de x. Podemos ahora usar la aproximación gaussiana de la probabilidad para

obtener una aproximación gaussiana para la densidad de probabilidad:

p N ( x) =

⎧ ( x − < x >) 2 ⎫

1

exp⎨−

⎬

2(∆x) 2 ⎭

2π ∆x

⎩

1

(Observe atentamente que efectivamente pN(x) tiene dimensiones de inversa de x mientras que PN(x) o

PN(n) son adimensionales como corresponde a una probabilidad). Para el caso de los espines el resultado

se obtiene sustituyendo x por µ en todas las expresiones anteriores. Observe la potencia del método que

permite, una vez resuelto el problema, aplicarlo a una variedad de problemas ilimitada. Todo lo que hay

que hacer es reinterpretar las expresiones.

Fíjese que para obtener valores medios usando la densidad de probabilidad hay que integrar:

< x >= ∫ xp N ( x ) dx

que usualmente es mucho más fácil de evaluar que una suma. Observe que los límites de la integral

pueden ser ± infinito, lo cuál no tiene sentido si estamos en el caso del borracho (y también en otros

sistemas) ya que con N pasos sólo se puede llegar a x=±NL. Sin embargo para esos valores (e incluso

mucho antes) la exponencial es totalmente despreciable así que contribuye de forma insignificante a la

integral, a cambio la integración puede ser bastante más fácil.

Puede ocurrir que la p(x) densidad de probabilidad tenga un valor infinito, esto no debe alarmar ya que es

la probabilidad p(x)dx es la que tiene que ser finita (menor que uno si está normalizada a la unidad). De

hecho la integral de la probabilidad debe ser finita (uno si esta normalizada a la unidad). En ocasiones

conviene hacer un cambio de variable, por ejemplo usar un variable y que esta relacionada con x por la

función y=y(x). Si esta función es monótona creciente o decreciente la densidad de probabilidad en

función de la nueva variable se obtiene trivialmente. Si no lo es hay que tener cuidado: la probabilidad

p(y)dy de encontrar el sistema en un intervalo y,y+dy es la suma de probabilidades p(x1)dx+p(x2)dx+...,

siendo y(x1)= y(x2)=...=y. Las dos figuras adjuntas muestran claramente el porqué.

y

y

y

y+dy

y

y+dy

x

x

x

x+dx

x1 x1+dx

x2 x2+dx

x3 x3+dx

(¡¡¡ EN EL RESTO DE ESTA INTRODUCCIÓN NO DEBE PERDERSE

EN EL ÁLGEBRA: FÍJESE MÁS EN LAS IDEAS!!!)

G. NAVASCUÉS

15 de Septiembre de 2005

11

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

2 CAMINO ALEATORIO PROBLEMA GENERAL

Ahora vamos a ver cómo se pueden generalizar las ideas anteriores a otros casos más complicados.

Aunque el álgebra es más engorrosa las ideas son las mismas. La generalización más inmediata, ya

insinuada anteriormente, es aquella en que los posibles resultados del suceso sean más de dos, por

ejemplo tirar un dado, en vez de una moneda, supone esperar que salga una de las seis puntuaciones

posibles del dado. Si el dado no está cargado cada cara tiene la misma probabilidad 1/6 de salir, en caso

en que no fuera así, en general, la cara con 1 punto tendría la probabilidad p1, la cara con 2 puntos

probabilidad p2, y así sucesivamente, y además, si queremos que las probabilidades estén normalizadas

debe verificarse que:

i =6

∑p

i =1

i

=1

Observe que estoy usando la notación más práctica para cuando hay más de dos resultados en un suceso.

En una sucesión de N sucesos (N tiradas del dado) la probabilidad de que salga, no importa el orden, n1

veces 1 punto, n2 veces 2 puntos, etc es la generalización de la distribución binómica:

PN (n1 , n2 , n3 , n4 , n5 , n6 ) = p1 1 p2 2 p3 3 p4 4 p5 5 p6

n

i =6

que con las condiciones

∑ pi = 1 y

i =1

i =6

∑n

i =1

i

n

n

n

n

n6

N!

n1!n2 !n3!n4 !n5!n6 !

= N . Observe que esta probabilidad es el término general del

polinomio ( p1 + p 2 + p 3 + p 4 + p 5 + p 6 ) . Observe que este caso se reduce al binómico haciendo p1=p y

N

p2=q (p3=p4=p5=p6=0) y n1=n, n2=N-n (n3=n4=n5=n6=0):

PN (n1 , n2 ) = PN (n1 , N − n1 ) = PN (n1 ) = p1 1 p2

n

n2

N!

N!

n

= p1 1 (1 − p1 ) n2

n1!( N − n1 )!

n1!n2 !

En general con N sucesos en donde hay M posibles resultados:

i=M

PN ({ni }) = ∏ p

i =1

i=M

i=M

N!

ni

i i=M

∏n !

i

siendo

∑p

i =1

i

=1

y

∑n

i =1

i

=N

i =1

La generalización puede ser de otro tipo: cada suceso puede generar dos o más resultados. Por ejemplo

en vez de tirar un dado se tiran dos dados, o un dado y una moneda o tres dados, o se observan las

posiciones de los átomos de nitrógeno de cinco moléculas de amoniaco o las orientaciones en una red de

espines, etc, etc. Aquí supondremos que los resultados observados en cada suceso son independientes

entre sí, es decir al tirar los dados lo que pase a cada uno de ellos no interfiere en lo que lo pase al otro:

son estadísticamente independientes. Lo mismo supondremos en cualquiera de los otros ejemplos. Así la

independencia estadística es doble en una cadena de sucesos (tirar los dados varias veces),

estos sucesos son independientes unos de otros (cada vez que se tiran los dados no importa

que es lo que haya ocurrido en las tiradas anteriores) pero también lo son los resultadas de

cada suceso (en cada tirada cada dado no es afectado por los otros). En general supongamos un

experimento de N sucesos, cada suceso tiene S resultados. El resultado i tiene Mi posibilidades La

expresión formal de estos casos se escribe:

{ }{ } { }

{ }

{ }

{ }

ΡN ( n (1) i , n ( 2 ) i ,..., n ( S ) i ) = P (1) N ( n (1) i ) × P ( 2 ) N ( n ( 2 ) i ) × ... × P ( S ) N ( n ( S ) i )

G. NAVASCUÉS

15 de Septiembre de 2005

12

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

donde he aprovechado la independencia estadística para factorizar la probabilidad. Cada factor es de la

forma:

i = Mk

P

(k )

N

{ }) = ∏ ( p

(n

(k )

N!

( k ) ni

i

i = Mk

i

i =1

)

∏n

(k )

i

!

i =1

i = Mk

con

∑p

(k )

i =1

i

=1

i = Mk

y

∑n

(k )

i =1

i

=N.

ΡN({ni},{mi},...) es la probabilidad de que en el experimento de los N sucesos, las posibilidades 1,2,... M1

del primer suceso ha salido n(1)1, n(1)2, ... veces respectivamente, las posibilidades 1,2,... M2 del segundo

suceso ha salido n(2)1, n(2)2, ... veces respectivamente, etc, etc. Por ejemplo si considero el experimento

de tirar tres veces un moneda y un dado (se tira tres veces: N=3; hay dos resultados cada vez: una

puntuación del dado y una de las caras de la moneda, por lo tanto S=2) que no están trucados (es decir

p(dado)i =1/6 y p(moneda)i =1/2) la probabilidad de que salga el uno del dado una vez, el dos una vez, el

cuatro una vez (por tanto ninguna vez el resto de las puntuaciones), la cara de la moneda dos veces (y

por tanto la cruz una vez), es

Ρ3 (n ( dado )1 = 1, n ( dado ) 2 = 1, n ( dado ) 3 = 0, n ( dado ) 4 = 1, n ( dado ) 5 = 0, n ( dado ) 6 = 0;

m ( moneda ) cara = 2, m ( moneda ) cruz = 1) =

= Ρ3 (n ( dado )1 = 1, n ( dado ) 2 = 1, n ( dado ) 3 = 0, n ( dado ) 4 = 1, n ( dado ) 5 = 0, n ( dado ) 6 = 0) ×

× P3 (m ( moneda ) cara = 2, m ( moneda ) cruz = 1) =

3!

×

1!1!0!1!0!0!

3!

× (1 / 2) n1 (1 / 2) n2

=

2!1!

= (1 / 6) n1 (1 / 6) n2 (1 / 6) n3 (1 / 6) n4 (1 / 6) n5 (1 / 6) n6

= (1 / 6) 3

3!

3!

× (1 / 2) 3 = ...

2

1

Observe como se simplifica el cálculo numérico si todas las pi son iguales.

La propiedad de independencia estadística tiene como consecuencia que el valor medio de una suma (o un

producto) es la suma de valores medios (o producto) de valores medios:

< a + b + ... >=< a > + < b > +...

< ab... >=< a >< b > .... .

Ver demostración en el libro de Reif. Este resultado es muy familiar ¿cual es el valor medio de la

puntuación de un dado? ¡3.5!. ¿Y si tiramos dos dados? pues la suma del valor medio de uno más el valor

medio del otro: ¡7!. No hace falta hacer ningún curso de estadística para predecir estos resultados. Bien

G. NAVASCUÉS

15 de Septiembre de 2005

13

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

pues la misma idea es la subyace en todo lo que he expuesto; simplemente he usado una descripción

matemática y he generalizado el problema.

3. TEOREMA DEL LÍMITE CENTRAL

(VER LIBRO DE REIF PARA MÁS DETALLES)

W(s)

W(s)

s

-d

s

d

w(si)dsi=probabilidad de desplazamiento en el rango si si+dsi

desplazamiento total después de N pasos: x=s1+s2+...+sN=∑si ⇒ <x>=N<s>, <s>=∫w(s)sds

................................................................................ ⇒ <∆x>=√N< ∆ s>, <s2>=∫w(s)s2 ds

P(x)dx=probabilidad de un desplazamiento x después de N pasos

+∞

⇒

P( x)dx =

+∞

∫ w(s )ds ∫ w(s

1

−∞

⇒

1

−∞

+∞

2

N

x < ∑ si < x + dx

)ds 2 .... ∫ w( s N )ds N

1

−∞

+∞+∞

+∞

+∞ +∞

+∞

N

− ∞− ∞

−∞

− ∞− ∞

−∞

1

P( x)dx =

∫

∫ ... ∫ w(s1 )w(s 2 )....w(s N )ds1ds 2 ...ds N =

∫

∫ ... ∫ w(s1 )w(s 2 )....w(s N )δ ( x − ∑ si )dxds1ds 2 ...ds N

N

x < ∑ si < x + dx

1

⇒

P( x)dx =

N

δ ( x − ∑ si ) =

1

+∞ +∞

+∞

N

− ∞− ∞

−∞

1

∫

1

2π

G. NAVASCUÉS

∫ ... ∫ w(s1 )w(s 2 )....w(s N )δ ( x − ∑ si )dxds1ds 2 ...ds N

+∞

N

⎧

⎫

dk

ik

x

si )⎬

exp

−

(

−

⎨

∑

∫−∞

1

⎩

⎭

15 de Septiembre de 2005

14

1 INTRODUCCIÓN A LAS DISTRIBUCIONES DE PROCESOS ALEATORIOS

⇒

P ( x) =

1

2π

+∞

N

∫ dk exp{− ikx}Q (k )

−∞

+∞

Q(k ) ≡ ∫ ds exp{iks}w( s )

W(s)

−∞

s

+∞

Q(k ) ≡

∫ ds exp{iks}[ pδ ( s − L) + qδ ( s + L)] = p exp{ikL} + q exp{− ikL}

−∞

N

Q N (k ) = ( p exp{ikL} + q exp{− ikL}) N = ∑

0

⇒

P ( x) =

1

2π

N

P( x) = ∑

0

+∞

N

−∞

0

∫ dk exp{− ikx}∑

N!

p n q N − n exp{ikL(2n − N )}

n!( N − n)!

N!

1

p n q N −n

n!( N − n)!

2π

G. NAVASCUÉS

N!

p n q N − n exp{ikL(2n − N )}

n!( N − n)!

+∞

N

−∞

0

∫ dk exp{ik ( L(2n − N ) − x)} = ∑

N!

p n q N − n δ ( L( 2n − N ) − x)

n!( N − n)!

15 de Septiembre de 2005

15