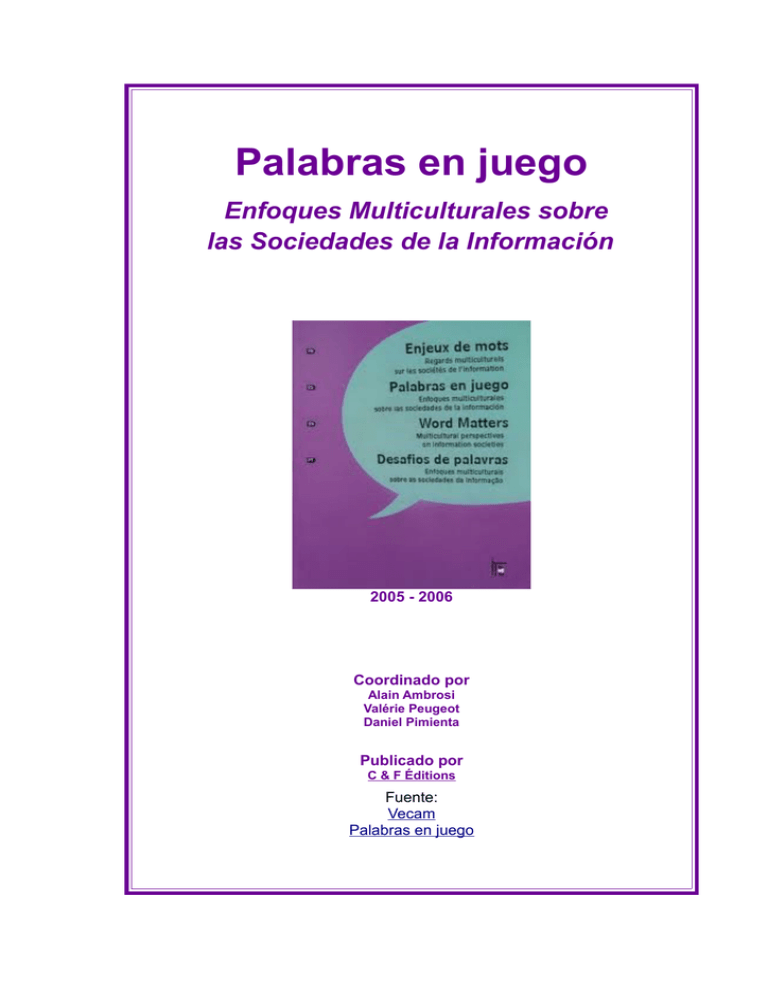

Palabras en juego

Anuncio