Fundamentos básicos de la Teoría de la Información

Anuncio

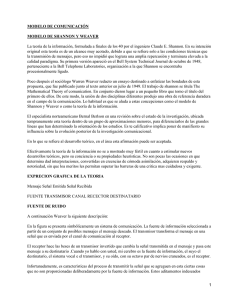

Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez Fundamentos básicos de la Teoría de la Información Dr. Mario Pérez Gutiérrez Observatori de la Comunicació Científica Universitat Pompeu Fabra y Departamento de Lógica y Filosofía de la Ciencia Universidad Complutense de Madrid E-mail: [email protected] 1. Introducción Desde los orígenes de la historia de la humanidad, las civilizaciones se han ido transformando y estructurando alrededor de los logros conseguidos a partir del aprovechamiento de una tecnología particular. El impacto de las técnicas de transformación derivadas del fuego, del carbón o del petróleo, desde el campo de la energía, o el progreso continuo que se ha producido en el ámbito de la producción industrial con el descubrimiento de nuevos y mejores materiales como el plástico o los superconductores son claros ejemplos de este fenómeno estructurador y transformador. Hoy en día, nuestra sociedad, a diferencia de otras anteriores, ya no se articula exclusivamente alrededor de algo tan material como una fuente energética o un conjunto de materias primas, sino que se encuentra protagonizando un proceso vertiginoso en el que todo comienza a estructurarse a partir de un serie de avances técnicos —de naturaleza más etérea, por así decirlo— que los expertos han convenido en denominar “tecnologías de la información”. La influencia de este tipo de tecnologías en nuestras vidas está alcanzando proporciones considerables. Nuestras relaciones políticas, las económicas, las sociales e incluso las personales se encuentran cada día más mediatizadas por eso que llaman “información”. Cientos de empresas se dedican a la compra, a la venta, al almacenamiento y a la gestión de información. Los gobiernos invierten muchos recursos para conseguir el control administrativo y policial de la población haciendo acopio de información personal. Millones de personas se encuentran relacionadas laboralmente de una manera estrecha con algún tipo de proceso en el que se ve envuelta la gestión de flujo informativo. Y en una carrera obsesiva por el progreso en el campo de esas tecnologías continuamente aparecen nuevos avances que están llegando a provocar profundos cambios en nuestras estrategias comunicativas personales y colectivas, en nuestro ocio y, en definitiva, en nuestra realidad más cotidiana. Este proceso se ha instalado de tal manera en nuestra cultura que incluso está provocando que la civilización contemporánea comience a ser identificada como la “sociedad de la información”. Pero el impacto de esas tecnologías y, en general, del fenómeno de la información no sólo se subscribe a esas parcelas de la actividad humana que acabamos de nombrar, sino que también se ve reflejado en el ámbito de lo teórico y de la investigación. De un tiempo a esta parte, especialmente desde principios de la década de los cincuenta, el tema de la información ha ido despertado el interés de los científicos de tal forma que, en cierta manera, ha llegado a vertebrar el panorama académico e intelectual contemporáneo. No existe disciplina alguna, ya sea del ámbito de lo que tradicionalmente se ha considerado como las Ciencias de la Naturaleza o de la parcela de la Ciencias Sociales, en la que no se apueste por un tratamiento o una mirada hacia este lugar común. En las Ciencias de la Computación y en la Inteligencia Artificial, debido a su especial naturaleza, el interés dedicado a la información parece obvio: intentar crear modelos conceptuales y físicos que representen, reproduzcan y, por qué no, mejoren las estrategias que utilizamos los seres vivos para producir y procesar flujo informativo. Pero también existen ejemplos de esta traslación del punto de interés que no parecen en un principio tan obvios. En biología, por ejemplo, se están dedicando grandes esfuerzos económicos y de personal para desentrañar y descifrar el papel crucial que juega la información en el interior de los Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez organismos considerados como conjuntos de mecanismos biológicos con capacidad de procesamiento de información. En psicología, el esfuerzo se dedica a la descripción y explicación de los procesos mediante los cuales los organismos codifican y transmiten información. Incluso en disciplinas tan aparentemente alejadas de estos paradigmas como la propia filosofía, el tema de la información está adquiriendo una gran fuerza como hipótesis explicativa en el campo de la epistemología y la acción humana. Sin embargo, aunque el interés por este fenómeno haya alcanzado en mayor o menor medida a casi todas las parcelas del panorama intelectual, en el centro de todo este movimiento académico y conceptual de final de siglo, la disciplina científica de la Documentación —y, por extensión, la Biblioteconomía— aparece ubicada en un lugar teórico privilegiado. Considerada con buen criterio por algunos como la genuina Ciencia de la Información, esta disciplina tiene como principal objetivo el tratamiento científico de aquellos temas que se encuentran relacionados con los principales soportes del contenido informativo: los documentos. En este sentido, debido a su especial naturaleza, la Documentación no puede darle la espalda a ese torrente caudaloso que fluye alrededor del concepto información y que recorre el panorama intelectual que nos ha tocado vivir. La disciplina de la Documentación debe hacerse eco de las distintas propuestas de análisis que sobre la noción de información se están realizando y encontrar así un territorio cada vez más sólido desde el que abordar explicativamente y con garantías los cambios que se aproximan de la mano de la implantación global de las tecnologías de la información y las consecuencias que éstas puedan acarrear en el campo de la gestión documental. Por este motivo, creemos que toda persona que quiera introducirse o completar su formación en temas de documentación (digital) debe pasar necesariamente por la revisión de algunas de las teorías que han intentado abordar el fenómeno de la información. Entre todas estas teorías destaca una en especial, la que se ha conocido con el nombre de "Teoría Matemática de la Comunicación". Esta propuesta teórica, presentada por Shannon y Weaver a finales de la década de los cuarenta, brilla con luz propia dentro del panorama intelectual ya que supuso el espaldarazo teórico definitivo para fundamentar la mayoría de los tratamientos ulteriores que se dedicaron al fenómeno de la información. Y con esta intención presentamos este artículo dentro de la Biblioteca digital del curso de postgrado Documentación Digital. Nuestro trabajo persigue el objetivo de intentar introducir a los alumnos de este curso en los fundamentos conceptuales y las principales ideas que conforman esa teoría. Para cubrir ese objetivo, desdoblaremos nuestra tarea en dos episodios diferenciados. Por un lado, en el apartado número dos, intentaremos realizar una exposición de las principales aportaciones de la Teoría Matemática de la Comunicación. En concreto, destacaremos su modelo explicativo del flujo informativo (apartado 2.1) e introduciremos las principales magnitudes informativas y el cálculo de la cantidad de información asociada a las señales que se sigue de los trabajos de Shannon y Weaver (apartado 2.2). Y por otro lado, en el apartado número tres, el artículo finalizará con el intento de realizar una breve evaluación de las principales aportaciones y limitaciones de esa propuesta teórica. 2. La Teoría Matemática de la Comunicación En la segunda mitad de los años cuarenta, en el prestigioso Massachusetts Institute of Technology (MIT) de Cambridge (Estados Unidos) se respiraba un estimulante ambiente de efervescencia intelectual. De la mano del prestigioso matemático norteamericano Norbert Wiener se estaba gestando lo que más tarde se conoció como "Cibernética" o "Ciencia General de los Sistemas". En esos años, Wiener, profesor de matemáticas del MIT, se interesó por los resultados de algunas investigaciones realizadas por biólogos, fisiólogos, físicos y psicólogos del momento dirigidas hacia el estudio del comportamiento de los organismos y el de las máquinas. En el año 1948, a partir de esos conocimientos e influenciado además por los trabajos del también matemático John Von Neuman, Wiener concentró el fruto de sus investigaciones en una obra titulada "Cibernética: o el control y la 2 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez comunicación en los animales y máquinas".1 En esa obra se intentaba presentar las bases de una propuesta científica, la cibernética, que tenía como objetivo la formulación de las leyes comunes que rigen tanto el comportamiento de los sistemas biológicos (el sistema nervioso de un organismo vivo, por ejemplo) como el de los mecanismos o sistemas no-biológicos o técnicos (un circuito eléctrico, por ejemplo). La cibernética pretendió ser una teoría general de los sistemas concebidos independientemente de su naturaleza física (biológica o mecánica) e identificados como un conjunto de elementos que, intercambiando señales, confieren un comportamiento como resultado. Unos años antes, en medio de ese ambiente intelectual que impregnaba el MIT, se incorporó como estudiante de ingeniería Claude Elwood Shannon. Allí destacó como alumno en los cursos de matemáticas que impartía el profesor Wiener y rápidamente se integró en la línea de investigación que, dirigida por ese mismo profesor en el departamento de matemáticas, estaba sentando las bases teóricas de esa nueva disciplina de la cibernética. Después de su graduación y de acabar su doctorado, Shannon abandonó Massachusetts y se instaló en Nueva York, donde se incorporó como ingeniero de telecomunicaciones en los prestigiosos laboratorios estadounidenses Bell Telephone, que constituían una filial de la empresa de telecomunicaciones American Telegraph &Telephone (ATT). En esos laboratorios, durante la segunda mundial, se dedicó a realizar trabajos de criptografía2 para el gobierno americano. En esa misma época, manteniendo el contacto con Wiener y con sus ideas, recibió también la influencia de los avances que en el campo de la biología estaba llevando a cabo Erwin Schrödinger con sus estudios sobre el papel de la transmisión de información en las investigaciones sobre genética y entró en contacto directo con Warren Weaver, coordinador de la investigación sobre grandes computadoras durante la segunda guerra mundial. En julio de 1948, Claude E. Shannon decidió recoger todas sus investigaciones en una obra y publicó un artículo en la revista Bell System Technical Journal, bajo el título de “A Mathematical Theory of Communication”,3 donde sintetizó los trabajos precedentes y presentó algunas ideas sobre la medida de la información articulándolas dentro de una teoría. Esta teoría pasaría a la historia con el nombre de “Teoría Matemática de la Comunicación”, aunque también ha sido conocida como la "Teoría Matemática de la Información" o simplemente como la "Teoría de la Información".4 En 1949, este artículo, junto a un prólogo de Warren Weaver, fue publicado como libro, con un título casi idéntico, por la University of Illinois Press.5 Esta obra se presentaba claramente divida en dos partes. En la primera parte, que recogía la contribución de Weaver, anticipaba en un lenguaje no matemático y divulgativo los principales conceptos y resultados del trabajo de Shannon. En esa misma parte, se incluía además, un modelo teórico que intentaba representar los elementos y las relaciones implicadas en un contexto en el que se ve implicado un flujo informativo. Ese modelo propuesto llegaría a tener tanta influencia en el desarrollo posterior de la teoría de la comunicación que consiguió eclipsar en parte otros de los logros conceptuales de esa obra. Y en la segunda parte, incluyéndose de nuevo el mismo modelo, Shannon presentó y desarrolló una teoría que tenía como objetivo principal la definición matemática de todas aquellas magnitudes que intervienen en las situaciones en las que se produce un flujo o transmisión de información, y conseguir, a partir de esas definiciones, un cálculo de la cantidad de información 1 WIENER, N. (1948). Cybernetics: or Control and Communication in the Animal and the Machine. 2 Disciplina que persigue la creación o la identificación de lenguajes cifrados. Un lenguaje cifrado es un sistema de comunicación interpersonal en el que el código sólo es compartido por un número limitado y expresamente conocido de individuos. 3 Shannon, Claude (1948). “A Mathematical Theory of Communication”. 4 A partir de este momento nos referiremos a esta teoría utilizando cualquiera de esos nombres. 5 Shannon, Claude y Weaver, Warren (1949). The Mathematical Theory of Communication. 3 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez que puede ser transportada a través de un canal y la identificación, además, de las formas de maximizar la eficacia de ese proceso. 2.1. El modelo explicativo del flujo informativo La colaboración de Warren Weaver comienza con una declaración de principios: la obra que está presentando intenta no sólo ser un modelo matemático de la información útil para los ingenieros, sino que persigue el objetivo más amplio de intentar dar cuenta de un fenómeno más general como el de la comunicación. Por "comunicación" Weaver entiende todo acto por el cual una mente (o mecanismo) puede afectar a otra mente (o mecanismo). Por tanto, dentro de los actos comunicativos hay que incluir no sólo aquellas situaciones en las que utilizamos el lenguaje natural con la intención de transmitir información a nuestros semejantes —ya sea mediante un acto de habla o de escritura—, sino que también hay que contemplar como tales la interpretación de una pieza musical, las artes plásticas, la puesta en escena de una obra de teatro, el ballet y, en general, cualquier conducta humana. En su empeño de abordar teóricamente y con garantías esta manera laxa de entender la comunicación, Weaver propone la distinción de tres tipos o niveles de problemas comunicacionales: el problema técnico, el semántico y el pragmático. Estos problemas pueden ser enunciados de manera más precisa de la siguiente manera: (i) Nivel A: ¿Con qué grado de exactitud se pueden transmitir los símbolos empleados en la comunicación? (El problema técnico). (ii) Nivel B: ¿Con qué grado de precisión transmiten el significado deseado los símbolos empleados en la comunicación? (El problema semántico). (iii) Nivel C: ¿Con qué grado de eficacia afectan los significados recibidos a las conductas? (El problema pragmático o de la efectividad). Cada uno de estos tres problemas genera una manera distinta de afrontar el tema de la comunicación. En un sentido amplio, podemos decir que si elegimos el nivel A trataremos de investigar sobre la fidelidad con la que un conjunto de símbolos es transferido o puede transmitirse desde un emisor a un receptor y, por tanto, intentaremos describir los detalles técnicos del diseño de un sistema de comunicaciones. De la misma manera, si nuestra opción es el nivel B, nuestro trabajo girará en torno al tema de la comparación entre el significado que el emisor le otorga a los símbolos empleados en la comunicación y la interpretación del significado de esos símbolos por parte del receptor. Por último, si nos concentramos en el nivel C, evaluaremos el éxito con el que la información transmitida ha afectado, en el sentido deseado, a la conducta del receptor. La dependencia entre los tres niveles puede parecer, en un principio, escasa o incluso nula. Pero, si bien los aspectos semánticos o los pragmáticos son superfluos para una descripción de los aspectos técnicos de los sistemas de comunicación, estos últimos no deben ser considerados como irrelevantes si queremos ofrecer, con garantías teóricas, un tratamiento semántico o pragmático de la comunicación. Weaver nos adelanta que el tratamiento que nos propone Shannon en la segunda mitad de la obra se concentra en el primer nivel de problemas. De todas formas, insiste en la idea de que de esa manera de acercarse al problema de la comunicación es posible extraer también un modelo que intente dar cuenta de todos los elementos y de las relaciones que forman parte de un contexto comunicativo en el que se produce un flujo o una transmisión de información. De manera general, el propio autor nos resume ese modelo a partir de la figura número 1. 4 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Fuente de Información Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez Transmisor Señal Mensaje Destino Receptor Señal Recibida Mensaje Fuente de Ruido Figura número 1.6 Como se desprende de esta figura, en el proceso comunicativo en el que se transmite cierta información intervienen, por un lado, cinco elementos (la fuente de información, el transmisor, el canal de comunicación, el receptor y el destino) dotados de unas funciones concretas, y, por otro lado, un factor de disfunción (la fuente de ruido). En concreto, este proceso puede describirse de la siguiente manera. En la fuente de información se selecciona un mensaje concreto (o una cadena de mensajes) de entre un conjunto de mensajes posibles (o de cadenas de mensajes posibles). El transmisor se encarga de transformar o traducir ese mensaje produciendo para ello una señal. Esta señal circula por el canal de comunicación, adecuándose al mismo, desde el transmisor hasta el receptor. El canal no es nada más que el medio material cuya alteración permite esa transmisión de la señal. El receptor, una especie de transmisor con la función comunicativa invertida, recibe esa señal y la traduce o la transforma en un mensaje que es reconducido a su vez hasta el destino. Desgraciadamente, en muchas ocasiones, el proceso que acabamos de describir no se produce tal y como esperábamos. En algunas situaciones concretas interviene una fuente de interferencias, distorsión o ruido que produce una diferencia significativa entre la señal original emitida por el transmisor y la recibida por el receptor. Esta diferencia entre las señales provoca que el mensaje que llega al destino no coincida con el que originariamente fue seleccionado en la fuente de información, frustrándose de esta manera el proceso o el intento comunicativo. Para ilustrar con más detalle el funcionamiento de este proceso sólo tenemos que recurrir a un par de sencillos ejemplos. Imaginemos, primero, el siguiente acto comunicativo. Una persona se encuentra en casa y, recordando que hoy es el día en el que un amigo suyo cumple años, decide realizar una llamada telefónica para felicitarle. En ese contexto, podemos decir que nuestro protagonista es la fuente de información, y la proferencia del enunciado ("¡feliz cumpleaños!", supongamos) que utiliza para felicitar a su amigo es el mensaje seleccionado, el mensaje que quiere transmitir. Este mensaje — estas palabras habladas, en definitiva— ha sido elegido de entre todas las posibles producciones lingüísticas, como por ejemplo "¡enhorabuena!" o "¡feliz aniversario!", que normalmente utilizamos para felicitar a alguien en el día de su cumpleaños. Su aparato de teléfono sería identificado como el transmisor de ese proceso comunicativo. Este aparato traduciría las palabras pronunciadas, los sonidos, en una señal eléctrica. Esa señal eléctrica se transmitirá a través del tendido o cableado telefónico que actuará de canal de comunicación en este caso. Gracias a ese cableado, la señal será 6 SHANNON, Claude y WEAVER, Warren (1949). The Mathematical Theory of Communication., pág. 7. 5 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez recibida en el aparato de teléfono de su amigo. Este aparato puede ser identificado como el receptor y transformará la señal eléctrica recibida en un mensaje, concretamente en una serie de sonidos que emitirá mediante el auricular. Por último, el amigo de nuestro protagonista debe ser considerado como el destino de ese acto comunicativo. Sin embargo, en algunas situaciones, puede ocurrir que en la línea telefónica, en el canal de comunicación, se produzcan interferencias o distorsiones que hagan variar la señal original emitida por el transmisor de tal forma que el receptor, el aparato telefónico del amigo, reciba una señal distinta. Esa variación en la señal eléctrica recibida acostumbra a provocar que, en aparato receptor del amigo, se escuchen nuevos sonidos o que se supriman algunos de los sonidos que en un principio aparecían en el mensaje original. Esta variación de mensajes puede, en muchas ocasiones, hacer peligrar seriamente la comunicación entre los dos personajes. Pasemos, ahora, al segundo de nuestros ejemplos ilustrativos. Supongamos que el protagonista de la historia anterior se encuentra paseando por el parque y que un extraño se le acerca y le pregunta la hora. Nuestro amigo responde: "las nueve y cuarto de la mañana". Analicemos ese acto comunicativo. En este caso podemos decir que la mente de nuestro protagonista es la fuente de información. El estado mental (un conjunto determinado de conexiones neuronales, una disposición neuronal, en definitiva) que experimenta cuando responde al extraño es el mensaje seleccionado, el mensaje que quiere transmitir. Este mensaje ha sido elegido de entre todas las disposiciones neuronales que normalmente experimentamos cuando comunicamos la hora. El sistema fónico (cuerdas vocales, nariz, boca, lengua, paladar, etc.) de nuestro protagonista debe ser identificado como el transmisor de ese proceso comunicativo. Este sistema traducirá o transformará la disposición neuronal en una señal sonora, en la proferencia del enunciado "las nueve y cuarto de la mañana". Esa señal sonora se transmitirá a través del aire que actuará en esta ocasión de canal de comunicación. Gracias al aire, la señal será recibida por el sistema auditivo de su amigo. Este sistema auditivo puede ser identificado como el receptor y transformará la señal acústica recibida en una señal eléctrica que generará una disposición neuronal en la mente del extraño. Por último, la mente del extraño debe ser considerada como el destinatario de ese acto comunicativo. De nuevo, hemos de destacar que en este ejemplo también puede intervenir una fuente de ruido. En algunas situaciones, puede ocurrir que el aire por el que circula la señal acústica, el canal de comunicación, se encuentre contaminado con otros sonidos que actúen a modo de interferencia o distorsión y que hagan variar la señal original emitida por el transmisor de tal forma que el receptor, el sistema auditivo del extraño, reciba una señal distinta. Esa variación en la señal acústica recibida acostumbra a provocar que en la mente del extraño se produzca una disposición neuronal, un mensaje, que no se corresponda con la que originalmente tenía nuestro protagonista. Y como pasaba anteriormente, esta variación en las disposiciones neuronales, en los mensajes, puede, en muchas ocasiones, hacer peligrar seriamente la comunicación entre los dos personajes del parque. 2.2. El cálculo de la cantidad de información La propuesta teórica defendida por Shannon y Weaver no se agota con la presentación del modelo que intenta describir los elementos y las relaciones que conforman un contexto comunicativo en el que existe un flujo o transmisión de información. Claude Elwood Shannon, en la segunda parte de la obra y haciendo suyo también el modelo anteriormente presentado, concentra su esfuerzos en la presentación de una teoría que sea capaz de definir matemáticamente las principales magnitudes que intervienen en las situaciones en las que se produce un flujo informativo. El espíritu de esta teoría se encuentra estrechamente relacionado con la investigación sobre la codificación y la transmisión de la información y alimentado por algunos problemas de ingeniería. En concreto, esta propuesta matemática fue diseñada, principalmente, para medir la cantidad de información que puede ser transportada a través de un canal y para identificar las formas de maximizar la eficacia de ese proceso. En ese sentido, los problemas que se persigue subsanar con esta teoría se agrupan alrededor de temas como el ahorro de tiempo y dinero en la transmisión de 6 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez señales, el diseño y el uso de canales que permitan transmitir la máxima cantidad de información, la búsqueda de códigos adecuados compatibles con el canal, la reproducción —de forma exacta o aproximada— en un punto determinado de una señal seleccionada en otro lugar o el desarrollo de canales sin ruido, por presentar sólo unos ejemplos. Dada la naturaleza de sus intereses prácticos, no es de extrañar que esta teoría surgiera de los estudios desarrollados por unos ingenieros de telecomunicaciones. Históricamente, antes de que se presentase la propuesta que aquí estamos analizando, las primeras e importantes aportaciones que se realizaron sobre la noción de información desde el ámbito de la matemática fueron introducidas por Harry Nyquist,7 en 1924, a partir de su trabajo sobre la velocidad de transmisión de mensajes telegráficos, y por R. Hartley,8 en 1928, con la introducción de la primera medida de la información de una señal s, I(s), relacionándola con su probabilidad:9 I(s) = log (1/p(s)). (donde p(s) es la probabilidad de la ocurrencia de s). Claude E. Shannon fue capaz de sintetizar y absorber esos trabajos precedentes y presentó sus ideas propias sobre el cálculo de la medida de la información integrándolas dentro de una propuesta teoría que más tarde, como ya indicamos, fue conocida bajo los nombres de ”Teoría Matemática de la Comunicación", "Teoría Matemática de la Información" o "Teoría de la Información". Para introducir las ideas principales de esa teoría debemos partir de la idea de que dentro de la misma los contextos informativos se consideran formados por fuentes (de información) que, a su vez, son definidas como conjuntos de acaecimientos, de señales, con cierta probabilidad de ocurrencia. Sin perder de vista esta distinción entre las fuentes de información y los acaecimientos (o señales) que las conforman, podemos introducir la primera de las definiciones que aparece en esta propuesta teórica. En concreto, presentaremos la ecuación que es utilizada para calcular la información asociada a una ocurrencia o señal si. La fórmula adecuada para medir la cantidad de información asociada a si (o su valor de sorpresa, I(si)), dada su probabilidad p(si), es: (1) I(si) = log 1/p(si) bits.10 = - log p(si) bits. (dado que log (1/x) = - log x) 7 NYQUIST, Harry (1924). “Certain Factors Affecting Telegraph Speed”. Cuatro años más tarde vuelve a insistir sobre este tema en NYQUIST, Harry (1928). “Certain Topics in Telegraph Transmission Theory”. 8 HARTLEY, R.V.L. (1928). “Transmission of Information”. 9 Una exposición detallada de la historia de las propuestas matemáticas que han intentado dar cuenta de la información puede encontrarse en CHERRY, E. Colin (1951). “A History of the Theory of Information”., y en CHERRY, E. Colin (1952). “The Communication of Information. An Historical Review”. 10 A lo largo de este artículo se utilizará “log n” como expresión del logaritmo en base dos de n. Al utilizar el logaritmo en base dos las cantidades de información aparecen en bits ya que un bit es la cantidad de información obtenida al especificar dos posibles alternativas igualmente probables. 7 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez I(si ) puede entenderse también como la información necesaria para representar que se ha producido la ocurrencia de si, o como el número de pasos o decisiones binarias (bits) necesarios para reducir n posibilidades de una fuente a una. Dentro de la Teoría Matemática de la Comunicación, la cantidad de información de un acaecimiento o una señal concreta sólo es considerado como un estadio para el cálculo de la cantidad media de información de una fuente que contiene varios acaecimientos con un valor de sorpresa propio. Para calcular esta media ponderada de información se utiliza la siguiente fórmula: (2) I(S) = p(s1) . I(s1) + p(s2) . I(s2) + p(s3) . I(s3) +...+ p(sn) . I(sn) = n ∑ i =1 p(si) . I(si) bits / señal. Por I(S), también llamada entropía, debemos entender el valor medio por símbolo de la información suministrada por la fuente S, o, también, el valor medio de la incertidumbre de un observador antes de conocer la salida de la fuente S. La importancia de esta cantidad dentro de la teoría presentada por Shannon —en detrimento de la de cantidad de información de una señal concreta— se justifica por el hecho de que es mucho más fructífera y útil a la hora de intentar diseñar soluciones a los problemas centrados en los aspectos de la ingeniería de la comunicación. Es poco útil intentar encontrar un canal que sirva para transmitir información exclusivamente en función de la cantidad de información asociada a una señal determinada de una fuente: si bien lograríamos que esa señal se transmitiese de una manera correcta, podría ser que para el resto de las señales de la fuente el canal utilizado no fuera adecuado. Es mucho más rentable diseñar un canal teniendo en cuenta el valor medio por símbolo de la información suministrada por la fuente. Hasta ahora hemos presentado el tratamiento de la cantidad de información generada por una fuente haciendo referencia exclusiva a señales o fuentes independientes, y para ello hemos introducido las fórmulas (1) y (2). Pero en la mayoría de los casos prácticos no podemos hablar de fuentes de información que sean independientes o que estén fuera de la influencia informativa de otras fuentes. A menudo, las fuentes se encuentran en relación informativa con otras fuentes. Cuando esto ocurre, cuando dos fuentes se encuentran relacionadas informacionalmente, decimos que entre ellas existe una transmisión o flujo de información. En estos contextos de interacción informativa, las definiciones de cantidad de información anteriormente expuestas no son suficientes para recoger matemáticamente este flujo o transmisión de información. En estas situaciones intervienen aspectos comunicativos que no son recogidos en la aplicación sistemática de las fórmulas presentadas. Cuando dos fuentes S y R se encuentran en relación informativa decimos que entre ellas existe un canal de información por el que se transmite un flujo de información. Podemos introducir la noción de canal de la siguiente manera: Definición. Un canal de información11 viene determinado por una fuente de entrada S = {si}, i = 1, 2, 3, ..., t; una fuente de salida R = {rj}, j = 1, 2, 3, ..., v; y un conjunto de probabilidades condicionales P(rj/si). P(rj/si) es la probabilidad de recibir en la salida el símbolo rj cuando se envía el símbolo de entrada si. También podemos representar gráficamente un canal de información con fuente de entrada S y de salida R mediante la siguiente figura: 11 Esta definición es aplicable sólo a lo que se considera un canal de información de memoria nula, es decir, a aquellos canales donde la probabilidad de una salida rj depende exclusivamente de una sola entrada si. Aunque aquí no se utilice es posible establecer una definición adecuada para canales con memoria no nula donde la probabilidad de cada una de sus salidas puede depender de más de un símbolo de entrada o incluso de otros símbolos de salida. 8 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez r1 r2 r3 s1 s2 S s3 P(rj /s i ) . . . st . . . rv R Figura número 2 Una vez introducida la noción de canal podemos pasar a describir las magnitudes informativas que intervienen en un contexto en el que existe un flujo informativo. En una situación en la que dos fuentes, S y R, se encuentren en una relación de transmisión informacional, además de sus cantidades independientes de información, I(S) y I(R), debemos atender a otras magnitudes informativas. Por un lado, partiendo de la idea de que existe un flujo informacional de la fuente S a la fuente R, una información generada en S y otra recibida en R, podemos introducir la noción de información mutua de S y R, IS(R), como la cantidad de información generada por S que se mantiene en R. La información mutua de S y R, IS(R), es también conocida como la información media mutua recibida por el canal o cantidad de dependencia de R respecto a S. Por otro lado también podemos introducir la noción de equivocidad, E, como la cantidad de información generada por S que no es transmitida a R; y la de ruido, N, como la cantidad de información que lleva R que no ha sido generada por S. En definitiva, éstas serían las magnitudes informativas asociadas a un canal: I(S), I(R), IS(R), E y N. Si representamos gráficamente estas nociones y sus relaciones podemos obtener el siguiente esquema: I(S) E S(R) I(R N Como se desprende de este esquema, para calcular los valores de IS(R), E y N debemos partir de la idea de que IS(R) nunca puede ser mayor que I(S) o I(R). De esta manera podemos afirmar que IS(R), la cantidad de información transmitida desde S a R, es la cantidad total de información disponible en R, I(R), menos la cantidad de ruido N: (3) IS(R) = I(R) - N. Por otro lado, como se sigue del esquema, también podemos afirmar que la cantidad de información transmitida de S a R, IS(R), es la cantidad total de información disponible en S, I(S), menos la equivocidad (E) o cantidad de información generada en S que no se transmite a R: (4) IS(R) = I(S) - E. Pasemos ahora a definir cuantitativamente las nociones de ruido y equivocidad. Para obtener la descripción matemática de la noción de ruido, N, es necesario primero conocer el ruido asociado a cada una de las ocurrencias si de la fuente entrada S. El ruido asociado a una ocurrencia si de la fuente entrada S puede calcularse utilizando la siguiente fórmula: (5) N(si) = - v ∑ j=1 p(rj/si) . log p(rj/si). 9 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez El ruido asociado a si es la suma de los resultados de multiplicar cada probabilidad condicional de recibir como salida cada símbolo rj de la fuente R siempre que se envía el signo fijo de entrada si, por el logaritmo en base dos de la misma. El signo menos que aparece precediendo al signo de sumatorio se justifica por la razón de que en (5) introducimos el logaritmo de una probabilidad. Los posibles valores de una probabilidad, p, se sitúan entre el 1 y el 0, y el logaritmo de un número mayor que 0 pero menor que 1 nos ofrece siempre un valor negativo. Por tanto, si p es distinto de 1 y de 0 pero se encuentra entre el 0 y 1, el logaritmo de p alcanza valores negativos. De todas formas, para evitar este signo negativo podríamos reescribir la fórmula (5) sustituyendo (al tener en cuenta que log 1/x = log x) log p(rj/si) por log 1/p(rj/si), pero esto complicaría la notación. Ahora, una vez que hemos podido calcular la cantidad de ruido asociada a una ocurrencia concreta si de la fuente de entrada S, estamos en condiciones de ofrecer una fórmula para calcular el promedio de ruido N: (6) N = p(s1) . N(s1) + p(s2) . N(s2) + p(s3) . N(s3) +...+ p(st) . N(st). = t ∑ i =1 p(si) . N(si). Esta fórmula nos indica que el promedio de ruido se obtiene de sumar los resultados de multiplicar cada probabilidad de ocurrencia de los estados individuales si de la fuente S por la cantidad de ruido asociado a si. De manera análoga, para obtener la descripción matemática de la noción de equivocidad, E, es necesario primero conocer la equivocidad asociada a cada una de las ocurrencias rj de la fuente de salida R: (7) E(rj) = - t ∑ i =1 p(si/rj) . log p(si/rj). (donde p(si/rj) = [p(rj/si) . p(si)] / p(rj)) La cantidad de equivocidad asociada a rj es la suma, multiplicada por menos uno, de los resultados de multiplicar cada probabilidad condicional de que se haya enviado como entrada cada símbolo si de la fuente S siempre que es recibido el signo fijo de salida rj, por el logaritmo en base dos de la misma. De nuevo, como ya se hizo en la fórmula número (5), el signo menos que aparece precediendo al signo de sumatorio se justifica por razones de simplificación en el cálculo y la notación, aunque podríamos reescribir la fórmula (7) sin ese signo si sustituyéramos log p(si/rj) por log (1/p(si/rj)). Una vez conocida la equivocidad asociada a cada ocurrencia rj de la fuente de salida R, estamos en disposición de poder calcular el promedio de equivocidad: (8) E = p(r1) . E (r1) + p(r2) . E (r2) + p(r3) . E (r3) +...+ p(rv) . E (rv). = v ∑ j=1 p(rj) . E (rj). Esta fórmula nos indica que el promedio de equivocidad se obtiene de sumar los resultados de multiplicar cada probabilidad de ocurrencia de los estados individuales rj de la fuente R por la cantidad de equivocidad asociado a rj. 3. La evaluación de la propuesta teórica Desde el momento en que fueron publicadas, las ideas que acabamos de presentar tuvieron un impacto científico de dimensiones considerables. Tanto el modelo explicativo de los actos de comunicación introducido por Weaver como la teoría matemática encaminada al cálculo de la 10 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez información presentada por Shannon influyeron y dejaron huella en casi todas las teorías que sobre estos temas aparecieron posteriormente. Las razones por las que estas ideas calaron y arraigaron dentro el panorama intelectual de la segunda mitad del siglo XX son de diversa índole. Si dejamos momentáneamente al margen de la propuesta matemática contenida en la segunda parte de la obra y concentramos primero nuestra atención sobre el modelo que intenta representar los contextos comunicativos introducido por Weaver podemos señalar que éste fue recibido con gran entusiasmo por la comunidad científica y rápidamente consiguió transgredir y superar el dominio para el que fue diseñado. Las razones de la buena acogida y del impacto positivo de este modelo pueden buscarse en las necesidades teóricas que recorrían el momento histórico en el que éste hizo su aparición. A principios de los años cincuenta, en los Estados Unidos, el interés de las Ciencias Sociales se centraba, principalmente, sobre diversas teorías encaminadas a explicar el ámbito de los comportamientos colectivos que se experimentan en el seno de la sociedad y la parcela del aprendizaje y la conducta en general. De esta manera, por un lado, los politólogos y los sociólogos de la época, interesados en encontrar una forma de abordar con garantías sus objetos de estudio, encontraron en el modelo de Weaver y en su explicación lineal de la comunicación, en esa manera de entender ese proceso como un fluir lineal de información desde la fuente hasta el destino, un camino adecuado para afrontar el tema de los efectos colectivos. Y, por otro lado, en el campo de la psicología, la misma linealidad explicativa de ese modelo se ajustó perfectamente al movimiento teórico que dominaba el panorama científico del momento y que se caracterizaba por ofrecer una descripción del aprendizaje y la conducta en términos de estímulo y respuesta. Pero la buena acogida del modelo de Weaver no sólo se justifica por el oportunismo histórico y coyuntural que le acompañó desde el momento en el que fue gestado. Lo que explica también ese impacto positivo de la propuesta y su influencia en las teorías posteriores es el haber sabido presentar un modelo que, si bien acompañaba a un trabajo encaminado a solucionar ciertos problemas cuantitativos en el campo de la ingeniería de la información, estaba dotado de un poder explicativo que se ajustaba perfectamente al tema de la comunicación humana en su sentido más amplio. De esta manera, con un diseño que podríamos calificar como "antropomórfico", se ofrecía la posibilidad de exportarlo con cierta facilidad a otros campos y modelizar, de esta forma, tanto la comunicación colectiva (la comunicación de masas, como la denominan algunos) como la comunicación interpersonal. Esta buena adecuación del modelo para dar cuenta de esos fenómenos estimuló el nacimiento de un largo camino teórico, todavía no ha finalizado, en el que los científicos sociales defienden la utilización del concepto de comunicación como hipótesis explicativa principal de toda la esfera de lo colectivo y, en definitiva, de lo humano. Sin embargo, el modelo defendido por Weaver no acabó imponiéndose de una forma rotunda y sin condiciones. Y es que la aparición de esa propuesta también generó y estimuló el trabajo crítico de otros científicos y pensadores. Las principales críticas que recibió estaban relacionadas con ciertas limitaciones del modelo. En concreto, por un lado, la propuesta proyectaba, dentro del proceso de comunicación, el mismo peso explicativo tanto a la fuente de información como al destino del flujo informativo. Y esto, claramente, no encajaba cuando se intentaba utilizar el modelo para dar cuenta de los actos de comunicación colectiva: en ese tipo de contextos el peso que tiene la fuente de información, los medios de comunicación de masas (prensa, radio, televisión, etc.), es mucho mayor que el que posee el destinatario final (lector, oyente, televidente, etc.). Y, por otro lado, esa misma linealidad explicativa del modelo tampoco permitía recoger algunas de las características esenciales de la comunicación interpersonal. En ese sentido, por ejemplo, la propuesta no conseguía representar la naturaleza dinámica del proceso de la comunicación que se concreta en la posibilidad de que en un contexto de este tipo el destino y la fuente de información intercambien sus papeles continuamente (el destino puede pasar a convertirse en la fuente de información y viceversa) dependiendo de la dirección del flujo, ni permitía tampoco reflejar esas situaciones en las que, aunque la información que fluye pueda ser interpretada de un modo diferente a como fue originalmente emitida, existe de todas formas un proceso comunicativo.12 12 Para revisar las crítica recibidas por este modelo y constatar la influencia de este enfoque sobre otros proyectos teóricos posteriores relacionados con la comunicación puede consultarse tambien: 11 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez Si pasamos ahora a revisar la propuesta de Shannon, hemos de señalar, sin embargo, que ésta no fue recibida con el mismo entusiasmo por la comunidad científica ni corrió la misma suerte que el modelo propuesto por Weaver. Sus virtudes teóricas son claras y se concentran, principalmente, en el hecho de haber contribuido de una manera definitiva al desarrollo de la ingeniería de telecomunicaciones y haber fundamentado científicamente, no sólo de forma matemática, los conceptos básicos —como el de entropía, información mutua, ruido, o equivocidad, por ejemplo— que más tarde serán utilizados por los comunicólogos y, en general, por todos aquellos investigadores del ámbito de las Ciencias Sociales que se han dedicado al estudio de la información o de la comunicación. Sin embargo, cuando revisamos la literatura dedicada a estos temas notamos no sólo que desaparece o se margina la contribución, sobre todo la cuantitativa, de Shannon, sino que además ésta recibe algunas críticas de amplio calado. Para comenzar es importante indicar que el bautismo que recibió esta teoría fue bastante desafortunado. El nombre con el que pasó a la historia no se corresponde, en lineas generales, con los contenidos de esta propuesta. El escaso interés demostrado hacia los aspectos semánticos o pragmáticos en favor de los aspectos técnicos impiden que la teoría presentada por Shannon pueda considerarse como una teoría matemática de algo tan estrechamente relacionado con el componente semántico como la comunicación. Además, por la misma razón, estrictamente hablando, esta propuesta tampoco puede considerarse como una genuina Teoría de la Información: sus intereses se centran exclusivamente en el cálculo de la cantidad de información asociada a las señales desatendiendo la cara semántica (la de los contenidos) de la moneda informativa. Quizá, el calificativo más adecuado sea el de “Teoría Matemática de la Cantidad de Información”. Algunos autores,13 sin embargo, en una posición más extrema, incluso van un poco más lejos llegando a defender que esta propuesta no puede clasificarse ni tan siquiera como una Teoría Matemática de la Cantidad de Información, sino que sólo debe ser considerada como una Teoría Estadística de la Transmisión de Señales.14 Pero las limitaciones de esta propuesta no se resumen exclusivamente al hecho de que recibiese un nombre desafortunado cuando fue bautizada. No olvidemos que, como ya hemos indicado anteriormente, el objetivo último de esta teoría es el tratamiento matemático de las cantidades de información. En este sentido, cuando evaluamos los beneficios explicativos que nos ofrece esta propuesta, podemos encontrar algunos problemas que pueden hacernos pensar que de esta teoría poco se puede aprovechar para satisfacer aquellos intereses teóricos centrados en el análisis semántico o pragmático de la información. Por un lado, de manera generalizada aparece un problema estrechamente relacionado con el uso posible de esta teoría: la grave dificultad que se presenta cuando intentamos aplicar sus fórmulas a situaciones concretas. En las situaciones cotidianas, a menudo es difícil conocer con exactitud la MATTELART, Armand y MATTELART, Michèle (1995). Historie des théories de la communication., MOLES, Abraham y ZELTMANN, Claude (eds.) (1975). La comunicación y los mass media., RODRIGO ALSINA, Miquel (1985). Los modelos de la comunicación., MCQUAIL, Denis y WINDAHL, Sven (1982). Communication Models for The Study of Mass Communication., WOLF, Mauro (1990). Teorie delle comunicazioni di massa., SAPERAS, Enric (1992). Introducció a les teories de la comunicació., y ABRIL, Gonzalo (1997). Teoría general de la información. 13 Como Yehoshua Bar-Hillel, en BAR-HILLEL, Yehoshua (1952). “Semantic Information and its Measures”. y en BAR-HILLEL, Yehoshua (1955). “An Examination of Information Theory”. 14 En BAR-HILLEL, Yehoshua y CARNAP, Rudolf (1952). “An Outline of a Theory of Semantic Information”., Bar-Hillel y Carnap proponen una alternativa semántica a esta propuesta. Pero aunque el título pueda indicar lo contrario, en ese trabajo no se ofrece ninguna definición de contenido informativo, sino que sólo se intenta definir las distintas relaciones (inclusión, equivalencia, etc.) que se pueden producir entre los contenidos informativos asociados a los enunciados de un sistema lingüístico. 12 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez mayoría de los valores de la probabilidad que conforman las ecuaciones, lo que hace casi imposible un cálculo numérico adecuado de las cantidades de información que intervienen.15 Y, por otro lado, nos encontramos con el problema consistente en que las definiciones matemáticas derivadas de la Teoría Matemática de la Comunicación no son de gran ayuda cuando intentamos descifrar el contenido semántico asociado a las señales: nos dicen cuánta información transporta una señal pero no qué información es transportada. Y esa independencia entre el cuánto y el qué queda de manifiesto si contemplamos los casos en los que dos señales pueden transportar la misma cantidad de información y sin embargo indicar contenidos informativos totalmente distintos. En estos casos, la teoría presentada por Shannon, asignándoles el mismo valor numérico, no es capaz de discriminar entre dos señales que claramente, desde un punto de vista semántico, son diferentes. En definitiva, para satisfacer de una manera más completa nuestros intereses explicativos referentes a la información, deberíamos buscar una teoría que sea capaz de discriminar la información de que p de la información de que q aunque estas dos informaciones sean indistinguibles desde el punto de vista cuantitativo. Y la Teoría Matemática de la Comunicación, claramente, no se encuentra preparada para recoger esta discriminación.16 Sin embargo, para acabar, hemos de señalar que todas estas limitaciones que presentan tanto el modelo defendido por Weaver como la propuesta de Shannon no deben impedirnos percibir el alcance real de esa apuesta teórica. Si bien han recibido duras críticas que han hecho tambalear sus virtudes explicativas, tenemos la obligación de indicar y subrayar que las ideas defendidas por estos ingenieros americanos deben ser valoradas en su justa medida y reconocer que han supuesto, no sólo el punto de arranque, sino también la fundamentación teórica necesaria para que el resto de los investigadores transiten con paso firme a través de ese estimulante proyecto que persigue la comprensión del fenómeno de la comunicación y de la información en todas sus dimensiones. 4. Bibliografía 4.1. Bibliografía principal New ABRAMSOM, Norman (1963). Information Theory and Coding. McGraw-hill Book Company, York. (Existe una traducción al español de esta obra realizada por Juan Antonio De Miguel Menoyo: ABRAMSOM, Norman (1986). Teoría de la información y codificación. Paraninfo, Madrid). BAR-HILLEL, Yehoshua (1952). “Semantic Information and its Measures”. En Transactions of the Tenth Conference on Cybernetics. Josiah Macy, Jr. Foundation, New York, págs. 33-48. BAR-HILLEL, Yehoshua (1955). “An Examination of Information Theory”. En Philosophy of vol. 22, págs. 86-105. Science. 15 Este problema se agudiza cuando intentamos aplicar estas fórmulas al uso que hacemos del lenguaje natural. Cuando utilizamos una lengua, cuando hablamos o escribimos, las palabras que usamos poseen una probabilidad de aparición que no se encuentra determinada exclusivamente por la propia lengua sino por todo el conjunto de palabras que con anterioridad hayamos utilizado en ese mismo contexto lingüístico. Esto convierte el lenguaje en una fuente de información con memoria donde es difícil decidir la probabilidad de ocurrencia de una palabra en concreto. 16 Algunos autores, sin embargo, como Fred I. Dretske (en DRETSKE, Fred I. (1981). Knowledge and the Flow of Information.), defienden la idea que es posible extraer, de ese desarrollo técnico que presenta Shannon, cierto beneficio explicativo. Yo mismo, en PÉREZ GUTIÉRREZ, Mario (1998a). “Teoría Matemática de la Comunicación y Teoría Semántica de la Información”. y en PÉREZ GUTIÉRREZ, Mario (1998b). Señal y contenido informativo: un análisis del concepto de información., también he mantenido que es posible extraer de ese modelo ciertas restricciones matemáticas que deben de ser tenidas en cuenta y respetadas a la hora de ofrecer una definición semántica satisfactoria de la noción información. 13 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez BAR-HILLEL, Yehoshua (1964). Language and Information. Addison-Wesley Publishing Company, Massachusetts. BAR-HILLEL, Yehoshua y CARNAP, Rudolf (1952). “An Outline of a Theory of Semantic Information”. En Technical Report No. 247 of The Research Laboratory of Electronics, Massachusetts Institute of Technology. CHERRY, E. Colin (1951). “A History of the Theory of Information”. En Proceeding of the Institute of Electrical Engineers, vol. 90, págs. 383-393. CHERRY, E. Colin (1952). “The Communication of Information. An Historical Review”. En American Scientist, vol. 40, págs. 640-664. COVER, T.M. y THOMAS, J.A. (1991). Elements of Information Theory. John Wiley & Sons, New York. ESCARPIT, Robert (1976). Théorie générale de l’information et de la communication. Librairie Hachette, París. (Existe una traducción al español de esta obra realizada por Araceli Carbó y Pilar Sanagustín: ESCARPIT, Robert (1977). Teoría general de la información y de la comunicación. Icaria Editorial, Barcelona). HARTLEY, R.V.L. (1928). “Transmission of Information”. En Bell System Technical Journal, vol. 7, págs. 535-563. NYQUIST, Harry (1924). “Certain Factors Affecting Telegraph Speed”. En Bell System Journal, vol. 3, págs. 324. Technical NYQUIST, Harry (1928). “Certain Topics in Telegraph Transmission Theory”. En A.I.E.E. Trans., vol. 47, págs. 617. PIERCE, John (1961). An Introdution to Information Theory. Symbols, signal and Noise. Publications, New York. Dover SHANNON, Claude (1948). “A Mathematical Theory of Communication”. En Bell System Technical Journal, vol. 27, págs 379-423, 623-656. SHANNON, Claude y WEAVER, Warren (1949). The Mathematical Theory of Communication. University of Illinois Press, Urbana. (Existe una traducción al español de esta obra realizada por Tomás Bethencourt Machado: SHANNON, Claude y WEAVER, Warren (1981). Teoría matemática de la comunicación. Ediciones Forja S.A., Madrid). WEAVER, Warren (1949). “Recent Contributions to The Mathematical Theory of Communication”. En SHANNON, Claude y WEAVER, Warren (1949). The Mathematical Theory of Communication. University of Illinois Press, Urbana. WIENER, N. (1948). Cybernetics: or Control and Communication in the Animal and the Machine. Wiley, New York. (Existe una traducción de esta obra al español: WIENER, N. (1971). Cibernética. Guadiana, Madrid). 4.2. Bibliografía secundaria (para continuar leyendo) ABRIL, Gonzalo (1997). Teoría general de la información. Ediciones Cátedra, Madrid. ARBIB, Michael A. (1964). Brains, Machines and Mathematics. McGraw-hill Book Company, New York. (Existe una traducción al español de esta obra realizada por Eva Sánchez Mañes: ARBIB, Michael A. (1976). Cerebros, máquinas y matemáticas. Alianza Editorial, Madrid). CODINA BONILLA, Lluis (1994). Teoria de sistemes, teoria de recuperació d’informació i documentació periodística. Tesis doctoral, Publicacions de la Universitat Autònoma de Barcelona, Bellaterra. (Una 14 Universidad Surcolombiana Programa de Comunicación Social y Periodismo Seminario de Teoría de la Comunicación II Prof.: Carlos Arturo Monje Álvarez versión resumida de esta tesis doctoral aparece publicada en CODINA BONILLA, Lluis (1993). Sistemes d’informació documental. Editorial Pòrtic S.A, Barcelona). DEVLIN, Keith (1991). Logic and Information. Cambridge University Press, Cambridge. DRETSKE, Fred I. (1981). Knowledge and the Flow of Information. The MIT Press/Bradford. Books. Cambridge, Massachusetts. (Existe una traducción al español de esta obra realizada por Margarita Vicedo, Montserrat Guilla y Fina Pizarro: DRETSKE, Fred I. (1987). Conocimiento e información. Salvat Editores, Barcelona). FERRER, Eulalio (1997). Información y comunicación. Fondo de Cultura Económica, México, DF. ISRAEL, David y PERRY, John (1990). "What is Information?". En HANSON, Philip P. (ed.) (1990). Information, Language and Cognition. University of British Columbia Press, Vancouver. MATTELART, Armand y MATTELART, Michèle (1995). Historie des théories de la communication. Éditions La Découverte, París. (Existe una traducción al español de esta obra realizada por Antonio López Ruiz y Fedra Egea: MATTELART, Armand y MATTELART, Michèle (1997). Historia de las teorías de la comunicación. Ediciones Paidós Ibérica S.A., Barcelona). MCQUAIL, Denis y WINDAHL, Sven (1982). Communication Models for The Study of Mass Communication. Addison-Wesley Publishing Company, London. (Existe una traducción al español de esta obra realizada por Charo Sádaba: MCQUAIL, Denis y WINDAHL, Sven (1984). Modelos para el estudio de la comunicación de masas. Ediciones Universidad de Navarra, Navarra). MOLES, Abraham y ZELTMANN, Claude (eds.) (1975). La comunicación y los mass media. Ediciones el Mensajero, Bilbao. NAUTA, Doede (1972). The Meaning of Information. Mouton, The Hague. PÉREZ GUTIÉRREZ, Mario (1998a). “Teoría Matemática de la Comunicación y Teoría Semántica de la Información”. En Teorema. (En prensa). PÉREZ GUTIÉRREZ, Mario (1998b). Señal y contenido informativo: un análisis del concepto de información. Servei d’Informació i Publicacions de la Universitat de Barcelona, Barcelona. RODRIGO ALSINA, Miquel (1985). Los modelos de la comunicación. Editorial Tecnos, Madrid. SAPERAS, Enric (1992). Introducció a les teories de la comunicació. Editorial Pòrtic S.A., Barcelona. SINGH, Jagjit (1966). Great Ideas in Information Theory, Language and Cibernetics. Dover, New York.. (Existe una traducción al español de esta obra realizada por Ana Julia Garriga Trillo: SINGH, Jagjit (1972). Ideas fundamentales sobre la Teoría de la Información, del lenguaje y de la cibernética. Alianza Editorial, Madrid). WOLF, Mauro (1990). Teorie delle comunicazioni di massa. Bompiani, Milano. (Existe una traducción al español de esta obra realizada por Carmen Artal: WOLF, Mauro (1996). La investigación de la comunicación de masas. Paidós, Barcelona). http://camelot.upf.es/digital/curs/rtf/mario.rtf 15