0705336_00000_0000.pdf

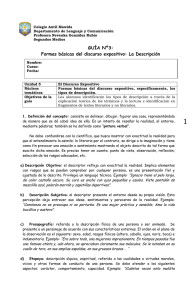

Anuncio